Ce travail examine prioritairement l’impact de la nouvelle technologie qui est entrée dans nos appareils et qui nous permet désormais de tout faire nous même, de la prise de la photo aux retouches faites directement sur l’appareil.

1. INTRODUCTION

2. CADRE HISTOIRIQUE DE LA PHOTOGRAPHIE

3. CAPTURE DE L’IMAGE

4. LES DIFFERENTS FORMATS D’IMAGE

- 4.1 Le format Bitmap ou BMP

- 4.2 Le format GIF

- 4.3 Le format JPEG

- 4.4 Le format HDR

- 4.5 Le format PNG

- 4.6 Le format TIFF

6. QUELQUES PROGRAMMES SUR ORDINATEUR

- 6.1 Adobe Photoshop (WindowsOs et MacOs)

- 6.2 Gimp (LinuxOs, WindowsOs et MacOs)

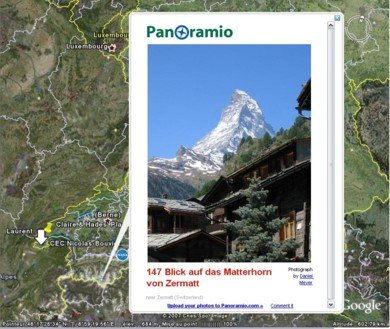

- 6.3 Google Earth

- 6.4 Panoramio

7. CONCLUSION - CE QUI A CHANGE

8. CONCLUSION PERSONNELLE

9. REMERCIEMENTS

10. BIBLIOGRAPHIE

11. ANNEXE I

La photographie, quelque chose qui est devenu banal de nos jours. Quasiment tout le monde possède un appareil photo, qu’il soit argentique, pour les nostalgiques de la pellicule, ou numérique, pour les fanas de nouvelles technologies. On n’hésite plus à sortir l’appareil photo, et c’est cela qui est agréable avec le numérique, on le trimbale avec nous et on le sort dès que l’on voit quelque chose qui nous plait et l’on prend, non plus une ou deux photos, mais cinq, dix, voir plus ! Mais parmi ces personnes, rares sont celles qui savent comment marche un appareil photo, les principes et le matériel employés, et qui connaissent les techniques pour obtenir de belles photos ; ils se contentent juste d’appuyer sur le bouton et de dire « souriez ! », « cheese ! », ou encore « le petit oiseau va sortir ! » en faisant confiance à leur appareil et en se disant « je vais faire une belle photo ». C’est sûr ce n’est pas aisé de comprendre comment ça marche. Il faut avoir quelques notions de physique, d’optique pour être précis et s’intéresser un peu à ce qu’il se fait dans le monde plus que complexe des nouvelles technologies, c’est là qu’interviennent les passionnés de photographie. Qui sont-ils ? Ce sont des gens à l’affût de la moindre nouveauté, et prêts à tout essayer, comme le dit le photographe Patrick Grob : « Ils sont souvent plus informés que nous sur ce qu’il se fait, ils essayent tout, ils lisent des magazines spécialisés, ils n’hésitent pas à s’acheter des appareils équivalant aux notre et voire mieux. »

Dans ce travail de recherche, je ne vais pas m’intéresser à la technique photographique au sens de comment faire une belle photo ou contrôler la luminosité, etc., mais plutôt à la nouvelle technologie qui est entrée dans nos appareils et qui nous permet désormais de tout faire nous même, de la prise de la photo aux retouches faites directement sur l’appareil (pas tous les appareils permettent de faire cela). Mais pour pouvoir parler de la photographie numérique il va falloir faire un petit détour par la bonne vieille photographie argentique par laquelle tout a commencé. Je vais commencer par parler, dans les grandes lignes, de l’histoire de la photographie, de l’évolution de quelques pièces matérielles importantes (le film, les capteurs, etc.) qui ont eu pour conséquence le passage de l’argentique au numérique, les différents formats d’image que l’on retrouve sur ordinateur, puis je vais parler, toujours sans trop m’étendre sur le sujet, du principe fondamental qui permet de prendre une photo, à savoir les lois de Descartes. Nous verrons aussi quelques programmes sur ordinateur, quatre pour être précis, deux utilisés pour retoucher les photos et les deux autres totalement différents puisqu’il s’agira de Google Earth, le fameux programme utilisant des photos satellites, et de Panoramio, enfin je ne veux pas tout dire maintenant, et finalement aux répercutions que cela a provoqué dans le milieu des photographes, avec une interview de l’un d’entre eux, Monsieur Patrick Grob, et dans la vie de « Monsieur tout le monde ».

2. Cadre historique de la photographie

Depuis longtemps le principe de base avait été découvert par Aristote au IVème siècle avant Jésus-Christ. Il avait découvert « que la lumière du jour pénétrant par un petit trou aménagé dans le mur d’une pièce obscure projette sur le mur d’en face l’image inversée de tous les objets placés à l’extérieur devant cet orifice » [1] . Il faut attendre le Moyen Age pour que des « alchimistes constatent le noircissement des sels d’argent exposés à la lumière et utilisent la " lune cornée "(nitrate d’argent) pour teindre ivoire, bois, cheveux » [2] .En 1515 la chambre noire est décrite par Léonard de Vinci (voir image ci-dessous).

En 1637, Descartes définit en premier les lois de l’optique, dans son fameux ouvrage intitulé La Dioptrique : « Quels que soient les angles d’incidence et de réfraction, le rapport de leurs sinus est toujours égal à une même constante lors de passages de la lumière entre deux milieux donnés » (pour plus d’informations, allez consulter le texte intégral de Descartes sur le site de l’Académie de Nice). La photographie quant à elle, n’a été inventée qu’en 1816 par un français du nom de Joseph Nicéphore Nièpce (photo).

C’est le premier à avoir obtenu des images stables en utilisant une chambre noire (voir photo ci-dessous). Mais il ne faut pas croire que tout était au point et que Nièpce a obtenu une belle photo en couleur, il n’a obtenu qu’un négatif sur chlorure d’argent fixé par de l’acide nitrique. Il continua à chercher des améliorations et en 1822, il utilisa du bitume de Judée étendu sur une plaque de verre et obtint une image positive, pas très nette est claire comme on en a l’habitude (voir photo ci-dessous).

En 1837, Hippolyte Bayard (photo du haut), un français, obtient les premières images positives sur papier issues de la chambre noire. En 1839, l’anglais Talbot (photo du bas) met au point le procédé négatif-positif (calotype).

Un français nommé Louis Ducos du Hauron (photo du haut) demande un brevet, en 1868, pour ses photos couleurs produites à l’aide de jaune, bleu et rouge. En 1888, l’américain Georges Eastman (photo du milieu) invente un appareil photo qui existe encore de nos jours, le Kodak (appareil jetable). Il s’agit d’une boite de 15 cm par 10 cm par 8 cm (voir photo du bas).

En 1923 Leiz invente le format 24-36. En 1937 les premières pellicules couleurs apparaissent (Kodachrome et Agfacolor). En 1948 le Polaroïd (photo du bas) est inventé par un américain, Edwin Land (photo du haut).

En 1981 Sony sort le premier appareil photo numérique, le Mavica. Les photos étaient enregistrées sur un disque magnétique d’une capacité maximum allant jusqu’à 50 photos.

Nous allons maintenant entrer dans le vif du sujet, à savoir la partie technique du travail.

Tout d’abord les pellicules. La pellicule photographique (ou film) est composée de différentes couches ayant chacune un rôle spécifique :

- une couche à base d’halogénures d’argent (sensible à la lumière)

- une couche anti-halo évitant la réflexion de la lumière lors de la prise

de vue - une couche anti-rayures protège le tout

Malgré ces diverses couches, le support reste souple et résistant à la fois, avec un faible coefficient d’élongation, c’est-à-dire que le support ne devient pas plus long après chaque photo et possède une bonne résistance au vieillissement.

La sensibilité d’un film (en ISO) est sa capacité à être impressionné par une quantité plus ou moins grande de lumière (plus le film est sensible et plus le temps d’exposition est cour). Elle est déterminée, tout comme la définition, par la taille et la forme des cristaux.

Mais alors comment arrive-t-on à la photo sur papier ? Et bien lorsque l’émulsion (les trois couches de la pellicule) est soumise à l’exposition de la lumière dans un appareil photographique, il se forme une image latente, invisible. Il faut ensuite faire développer le film pour obtenir une image visible.

On va s’intéresser maintenant aux pellicules noir/blanc et pellicules négatives/positives couleurs.

Le film noir et blanc est constitué :

– d’une couche de protection,

– de cristaux d’halogénure d’argent incorporés à de la gélatine,

– de matière plastique transparente,

– d’une couche anti-halo

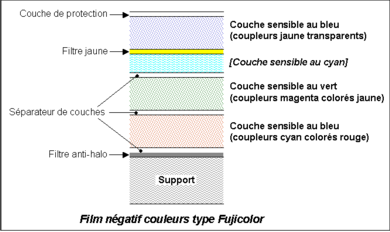

3.1.2 Pellicule négative couleur

Cette pellicule consiste en son principe à la superposition de trois couches photosensibles à savoir le bleu, le rouge et le vert. Tout cela est posé sur un support et séparé par des couches de séparation. Entre la couche de vert et de bleu se trouve le filtre jaune pour que le bleu ne pénètre pas le film.

La couche sensibilisée au bleu se colore en jaune, la couche sensibilisée au vert se colore en magenta avec un secondaire jaune et la couche sensibilisée au rouge se colore en cyan avec des secondaires magenta et jaune.

Les grains de bromure d’argent sensibles à la lumière et un coupleur permettront de former un colorant au cours du développement chromogène. Lors de celui-ci, chaque coupleur réagit à proximité des grains d’argent exposés et libère un colorant de couleur complémentaire. Ces colorants sont toutefois insuffisamment sélectifs et "polluent" le rendu des autres couches. Pour compenser ces colorations secondaires, un "masque" est ajouté aux 2 dernières couches ; pour la couche "vert" un masque jaune et pour la couche "rouge" un masque magenta et jaune.

3.1.3 Pellicule positive couleur – diapositive

Idem que pour le film couleur sauf que le développement chromogène produit directement des couleurs en positif.

Le CCD et le CMOS sont les « nouvelles pellicules » du XXIe siècle. Leur fonction est de convertir la lumière qui les frappe en une image visible, le gros changement est dans la manière d’enregistrer cette image :

- pour les argentiques, ce sont les cristaux argentiques qui marquent

définitivement l’image - pour les numériques l’image est codée par des suites de 0 et de 1

Un autre grand changement c’est de pouvoir modifier la résolution de prise de vue du capteur. On peut l’augmenter, mais alors le nombre de photos que l’on peut prendre diminue car chacune occupera une place plus importante sur la carte mémoire de l’appareil. A l’inverse si l’on diminue la résolution, on diminue le poids de la photo et donc on pourra en stocker plus sur la même carte mémoire. Cela n’est pas possible pour la prise de vue argentique où la pellicule sert aussi à stocker les photos prisent. Examinons maintenant chacun de ces capteurs.

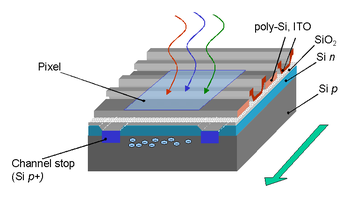

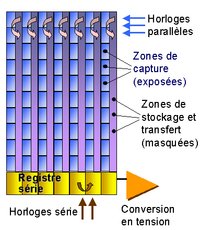

Le CCD (Charge-Coupled Device, ou détecteurs à couplage de charge) a été mis au point par les Laboratoires Bell en 1969 et a été rapidement introduit dans le milieu de l’imagerie astronomique puis dans le marché grand public, avec les caméras et les appareils photographiques.

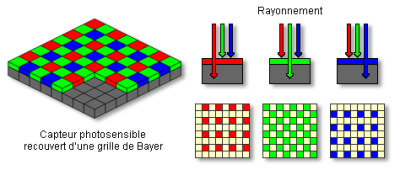

Le CCD est le plus simple des deux à fabriquer. Selon le modèle du capteur CCD, il n’est pas constitué de la même façon. Je m’explique, soit se sont des photosites qui le composent, soit se sont des cellules sensibles au rayonnement lumineux. En fait les deux sont des types de photodiodes car lorsqu’ils sont frappés par les rayons lumineux, ils produisent une impulsion électrique proportionnelle à la quantité de lumière reçue. Un convertisseur analogique/numérique intégré dans l’appareil code l’impulsion sur une suite de huit bits, c’est-à-dire que l’information est enregistrée sur la carte mémoire, contenue dans l’appareil, sous forme de 0 ou de 1. Ces 0 et ces 1 correspondent à deux états différents, si le 0 représente l’un des deux alors l’autre est représenté par le 1. Deux possibilités (0/1) sont égales à un bit, quatre sont égales à deux bits (00/01/10/11), 256 (28) possibilités correspondent à huit bits, et ainsi de suite. Chaque fois que l’on a 256 possibilités ou huit bits, on obtient un octet, 16 bits correspondent à 216 ou à 2562 ce qui donne 65536 possibilités, etc. Chaque couleur est codée sur un octet vu que chaque cellule photosensible reçoit une couleur déterminée par le filtre qui est posé sur le support regroupant ces cellules, ces dernières produisent une impulsion électrique. Chaque impulsion vaut huit bits, il faut prendre en compte les trois couleurs, rouge, vert et bleu, donc cela nous donne 24 bits (trois octets) ou 2563 qui est égal à environ 16.8 millions de couleurs possibles en tout. Comme je l’ai mentionné un peu plus haut, chaque photodiode est recouvert d’un filtre coloré qui ne laisse passer qu’un certain type de rayons lumineux en fonction de leur température, c’est ce qu’on appelle une grille de Bayer (photo).

L’intensité d’une seule couleur primaire (rouge, vert et bleu) est mesurée avec précision par chacune des photodiodes. Un processeur intégré lui aussi à l’appareil a pour but de combler les données manquantes. En effet lorsqu’une photodiode est recouverte d’un filtre rouge, il va manquer au pixel final correspondant à cette photodiode, des informations sur le vert et le bleu et ainsi de suite pour chacune des photodiodes. Heureusement il y a le convertisseur qui va calculer ce qui manque en se basant sur les couleurs des autres pixels se trouvant à proximité, c’est ce qu’on appelle une interpolation de couleurs. On obtient de très bons résultats mais il faut faire attention car dans certains cas (grand contraste par exemple), la performance diminue et on n’obtient pas la même qualité finale. En fait, chacune de ces photodiodes sera représenté par un pixel (un point), le tout composera l’image finale. Le capteur CCD possède bien évidemment une sensibilité, tout comme son ancêtre la pellicule, notée en ISO (qui signifie en français : Organisation internationale de normalisation), plus la valeur est haute et plus le capteur sera sensible à la lumière. Mais le plus qu’ont les capteurs CCD et CMOS, c’est que l’on peut régler leur valeur ISO directement sur l’appareil photo en allant simplement dans le menu, tandis qu’avant on devait changer de pellicule ; maintenant c’est fini !

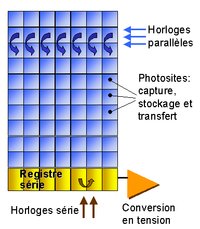

Il existe trois types de CCD :

- Le CCD pleine trame (full frame) : c’est le plus sensible des trois car l’ensemble de sa surface contribue à la détection de la lumière.

- Le CCD à transfert de trame (full-frame transfert) : Il est composé de deux capteurs CCD identiques mais l’un des deux est exposé à la lumière et l’autre pas. Le but de ce dispositif est d’accélérer le transfert de la matrice CCD qui est exposée vers l’autre qui sert de lieu de stockage. Pendant qu’on fait une photo, la précédente est numérisée.

- Le CCD interligne : il est le plus complexe de tous et le plus utilisé des CCD car on a implanté à chaque cellules du capteur, une photodiode.

Le principal attrait du CCD est sa résolution (en millions de pixels), c’est-à-dire la quantité de pixels qui composeront l’image finale. Il va sans dire que plus celle-ci est élevée, plus l’image résultant de la prise de vue sera détaillée et plus elle pourra être imprimée dans un grand format, par exemple 20x27 au lieu de 10x13, sans que l’on remarque les pixels.

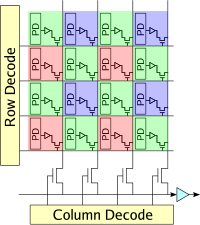

Les capteurs CMOS (Complementary metal oxide semi-conductor) sont apparus dans les années 1980, à la suite des matrices de photodiodes, comme le résultat de l’intégration de cellule composée d’une photodiode et d’une logique d’amplification puis d’obturation. Ils sont plus complexes à fabriquer mais sont produits selon des techniques classiques de micro-électroniques et de ce fait peuvent avoir des dimensions importantes (14 mégapixels en 2003). De la même façon que beaucoup de CCD, les capteurs CMOS pour image couleur sont associés à un filtre coloré et à un réseau de lentilles, encore plus nécessaire vu la faible surface relative de la photodiode, seule zone sensible.

4. Les différents formats d’images

Le format Bitmap, ou BMP, est le format d’image Windows standard, utilisable par quasiment tous les programmes et éditeurs d’images. Il a été développé par Microsoft et par IBM. Il supporte plusieurs variantes de couleurs possibles. L’image peut être codée en 1, 2, 4, 8, 16 ou 24 bits. Les images codées en BMP sont très lourdes, ainsi une photo pesant 2.29 Mo en JPEG, pèse 17.2 Mo en BMP 24 bits !!!

Le format GIF pour Graphics Interchange Format, a été mis au point en 1986 par CompuServe, une entreprise américaine, dans le but de télécharger des images couleur de petite taille, car les ordinateurs de l’époque ne pouvaient pas supporter de trop grandes images de par le fait que leurs cartes graphiques n’étaient pas assez puissantes (256 couleurs pour les meilleures). Ce format a une compression sans perte car il utilise l’algorithme LZW, au contraire du RLE utilisé pour le format JPEG (que l’on verra plus loin). Le GIF code un pixel avec au maximum 256 valeurs ; je m’explique : pour chaque image il y a de 2 à 256 couleurs possibles, le GIF n’enregistre pas directement la couleur de chaque pixel et comme un pixel correspond à un nombre compris entre 2 et 256, l’image finale ne dépassera pas 256 couleurs (on l’appelle aussi format 8 bits pour cette raison), je le rappelle, valeur maximale supportée par les cartes graphiques de l’époque. Ce format est beaucoup utilisé sur internet, car il permet un affichage plus rapide des images tout en donnant un résultat correct. Son inconvénient c’est qu’il faut payer des droits pour l’utiliser.

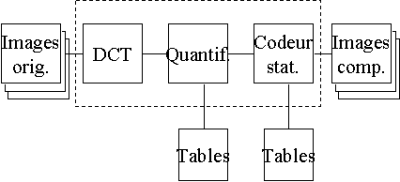

Le format Joint Photographic Experts Group, plus connu sous le nom de format JPEG, sert à la compression d’images par des algorithmes. Pour compresser une image brute, le JPEG va tout d’abord couper cette image en petits carrés de 64 ou 256 pixels, puis il code les couleurs, il transforme numériquement chaque petit carré et chaque couleur en fréquence et amplitude, c’est ce qu’on appelle une transformation DCT pour Discret Cosine Transform, arrive la quantification, c’est ici que l’on commence à compresser l’image, le but est de diviser la matrice obtenue après l’étape du DCT par une autre matrice (matrice de quantification) de taille égale, le résultat est l’atténuation des hautes fréquences que l’œil humain ne peut pas voir. Intervient maintenant les deux dernières étapes, le codage en RLE (run-length encoding, appelé en français le codage par plages) « consiste alors à indiquer pour chaque suite de pixels d’une même couleur, le nombre de pixels de cette séquence », d’après [3] puis finalement le codage de Huffman qui permet de compresser, sans perdre de données, « les octets revenant le plus fréquemment avec une séquence de bits beaucoup plus courte que d’ordinaire », d’après [4]

Exemple (tiré de Wikipédia) :

B = pixel noir

W = pixel blanc

Avant encodage :

WWWWWWWWWWWWBWWWWWWWWWWWWWWBBBWWWWWWW

WWWWWWWWWWWWWWWWBWWWWWWWWWWW

Après encodage :

12W1B14W3B23W1B11W

Schéma de codage :

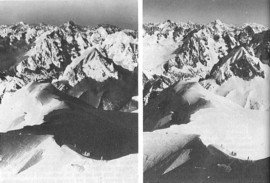

Il s’agit de prendre plusieurs photographies (entre 3 et 6, mais c’est possible avec plus) l’objet ou le paysage que l’on veut mais à veillant à changer, à chaque nouvelle photo, l’ouverture de façon à avoir à chaque fois une luminosité différente. Ensuite grâce à un programme sur ordinateur, on réuni tous les clichés en une seule et même photo, ce qui donne une photographie de meilleure qualité que si l’on ne prenait qu’un seul cliché.

Exemple :

Le PNG qui signifie Portable Network Graphics, ou format Ping, a été mis au point en 1995 pour lutter contre le format GIF, format pour lequel il faut payer des droits comme je l’ai déjà dit, donc le PNG est libre et peut être utilisé par tous. Il peut stocker des images en noir et blanc jusqu’à 16 bits, en couleur jusqu’à 48 bits mais aussi comme le GIF en 256 couleurs. Il utilise comme ce dernier un algorithme sans perte.

Le format TIFF ou Tagged Image File Format, a été mis au point en 1987 par Adobe. Ce format est l’équivalent du BMP mais en beaucoup mieux. Il permet de stocker des très grosses images (plus de 4 Go) sans perte de données. On peut stocker des images noir/blanc, couleurs ainsi que des images utilisant une palette de couleurs, comme pour le format PNG.

Les lois de Descartes nous disent tout d’abord que le rayon réfracté reste dans le plan d’incidence et que les angles provoqués par le rayon incident, dit rayon d’incidence, et celui provoqué par le rayon réfléchi, dit de réfraction, sont liés par la relation :

n1sin î1 = n2 sin ?

où n1 et n2 sont des constantes numériques, appelés aussi indices absolus, propres à chaque milieux.

5.2 Les différents types d’appareils photo

Il existe deux types de réflex, outre le fait qu’ils soient argentique ou numérique, les mono-objectifs et les bi-objectifs. Les mono-objectifs ont un miroir basculant qui reflète directement la lumière sur le capteur ou la pellicule. Les bi-objectifs possèdent donc deux objectifs qui couvrent le même rayon d’action ; l’on vise avec le deuxième car les rayons lumineux traverse ce dernier puis arrivent contre un miroir où ils sont reflétés vers un verre dépoli.

5.2.2 Les appareils télémétriques

Ils utilisent un télémètre pour faire la mise au point. L’on vise dans un viseur séparé de l’objectif.

Ce sont les plus connus car les plus utilisés. Ils sont petits, légers et souvent tout automatisés, un des plus connu est le jetable. L’on vise dans un viseur séparé de l‘objectif.

Ce sont des appareils bioniques, mi réflex, mi compact. Ils possèdent deux modes, soit tout automatique, soit tout manuel, et un objectif unique. Ils sont réapparus avec le numérique et proposent ainsi une alternative pour ceux qui veulent avoir un appareil où les réglages manuels sont possibles, sans trop d’électronique, qui a une bonne qualité photo et tout cela pour un prix raisonnable.

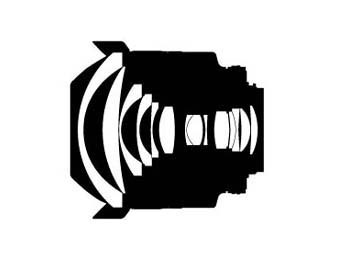

Par objectif standard, j’entends par-là un objectif de 50 mm. Nikon en fait trois sortes différentes. Il existe un objectif standard ultra-lumineux, un ultra-compact et un rapide.

5.3.2 Le zoom optique et numérique

Le zoom a été inventé en 1949 par un ingénieur français du nom de Roger Cuvillier.

Un zoom est un objectif à focale variable : une bague permet de modifier la focale de manière continue, ce qui modifie en même temps l’angle de prise de vue et donc la taille apparente des éléments de l’image, mais pas la perspective des objets photographiés.

De manière traditionnelle, nous venons de voir que grossir une image consiste à augmenter la longueur focale d’un objectif. Si ce dernier est de bonne qualité, la photographie en résultant ne doit souffrir d’aucun artefact, puisqu’il ne s’agit que d’employer de simples règles d’optique. En revanche, le zoom numérique présent sur la plupart des appareils est, pour sa part, à proscrire. En effet, il procède de manière logicielle, en recadrant une partie de l’image et en calculant les nouveaux pixels par interpolation. Il en résulte une image truffée artefacts en tous genre : contours des objets très marqués, bruit, effets d’escalier, etc.

5.3.3 Construction optique d’un zoom

Le zoom est techniquement un objectif comportant plusieurs groupes de lentilles, dont certaines sont mobiles : ce qui permet d’en faire varier la distance focale entre deux valeurs extrêmes. Dans la pratique, il faut aussi conserver la netteté de l’image lors de la variation de focale. De ce fait, plusieurs groupes de lentilles peuvent se déplacer de manière différente, lors d’un changement de focale. L’objectif peut voir sa longueur totale évoluer lors de la variation de focale. Ce rallongement avec l’augmentation de la focale est la règle générale. Mais il existe des objectifs transtandards pour lesquels la lentille frontale s’avance à la fois en position grand angle et en position téléobjectif, la longueur minimale étant atteinte pour une focale intermédiaire. D’autres objectifs ne changent pas de dimensions lorsque la focale évolue, seules les lentilles internes bougent. Pour d’autres enfin, c’est en raccourcissant la focale que le bloc optique frontal avancera.

5.3.4 Défauts optiques des zooms

On s’en doute, un zoom est au moins sujet aux mêmes défauts optiques que les focales fixes qu’il remplace.

1) La distorsion :

C’est un défaut que possèdent tous les zooms du fait des dissymétries au niveau de la disposition des lentilles. Un zoom transtandard présente couramment une forte distorsion en barillet, c’est-à-dire que l’image est plus grande que l’objet visé, à sa plus courte focale (voir photo). Cette distorsion diminue rapidement lorsqu’on augmente la focale de quelques millimètres, puis, après être passé par une focale sans distorsion, on obtient une distorsion en croissant, c’est-à-dire que l’image est plus petite que l’objet visé, c’est le contraire de la distorsion en barillet (voir photo). Un télézoom d’amplitude modérée (3x), peut lui aussi avoir une (légère) distorsion en barillet à sa plus courte focale, mais aura une distorsion en croissant aux focales supérieures. Un zoom grand angle présente une distorsion en barillet à sa plus courte focale. Cette distorsion diminue régulièrement avec l’augmentation de la focale, mais il peut encore subsister une légère distorsion (en barillet ou en croissant) à la focale la plus longue. En théorie, ce sont les zooms grand angle qui devraient présenter les distorsions les plus importantes. Dans la pratique, le fabricant peut choisir de bien corriger ce défaut, notamment au moyen de lentilles asphériques.

2) Le vignetage :

Il est surtout présent à pleine ouverture en position grand angle, que l’on utilise un zoom grand angle ou un zoom transtandard. En augmentant la focale d’un zoom, le vignetage devient plus modéré voire imperceptible.

Cet objectif permet de prendre une photo de quelque chose (objet, paysage,…) dans son ensemble grâce à un cadrage large dû à sa petite focale. Il permet de faire notamment des panoramas. Il en existe différents modèles, du 35mm au 12mm. Le problème avec les nouveaux appareils réflex numériques, c’est que le capteur est plus petit que la bonne vielle pellicule et que donc les divers fabricants ajoutent un coefficient multiplicateur, en général de 1.5. « La seule solution pour construire un objectif pour un boîtier réflex est de placer le bloc de lentilles de courte focale plus loin du plan film ou du capteur qu’il devrait l’être pour fournir une image nette. Dans de telles conditions, l’objectif ne fournira une image nette que pour des objets rapprochés ou très rapprochés. Pour corriger la netteté des objets éloignés, on rajoutera une ou plusieurs lentilles divergentes à l’avant de l’objectif. », d’après [5]

Cet objectif permet de prendre des photos d’objets à seulement quelques centimètres de l’objectif. Il est utile pour prendre des petits détails par exemple un insecte sur une fleur. Il existe un choix compris en 50mm et 200mm pour la distance focale.

La mise au point est l’opération qui consiste, pour un photographe, à régler la netteté de l’image qu’il veut obtenir. Cette netteté est très liée à la profondeur de champs.

5.4.1 La mise au point automatique

Les appareils modernes sont presque tous dotés de la mise au point automatique dite "AF" pour Autofocus (la traduction en anglais du terme "mise au point automatique").

Le viseur de l’appareil montre des zones de l’image de visée sur lesquelles l’utilisateur va effectuer la mise au point en pointant l’objet qu’il veut voir net et en pressant le déclencheur à mi-course. Si l’appareil est suffisamment perfectionné, l’utilisateur peut alors recadrer avant de prendre la photo. Sur les appareils les plus performants, en général des reflex, il est possible de choisir la zone de mise au point. La technologie de la mise au point s’effectue grâce au contraste d’une image ; c’est pour cela qu’une situation avec une faible lumière (donc faible contraste) pose des problèmes de mise au point.

5.4.2 La mise au point manuelle

Comment faisait-on avant la mise au point automatique ? Et bien on avait le choix entre plusieurs techniques possibles. Il y avait la méthode « bon ça doit la faire » où l’on jugeait plus ou moins les réglages à effectuer selon la distance de l’objet que l’on voulait photographier, mais cette « technique » n’est pas vraiment précise comme on peut le penser, mais elle est suffisante pour faire un paysage. Il existe une autre technique : celle du verre poli. Elle consiste à introduire dans le viseur un bout de verre dépoli qui contient au milieu un cercle lui-même séparé par son diamètre. Cela fait que quand on vise l’objet, on le voit en deux parties, la mise au point se fait en ajustant la bague de réglage de la distance située sur l’objectif, afin que l’image fragmentée en deux se « recolle » et ne forme plus qu’une seule image.

Il existe enfin une dernière méthode, le télémètre à superposition. Le dispositif est inséré dans le viseur, tout comme le verre poli, et consiste à créer deux images identiques de l’objet sur le quel on vise. Le but du jeu est d’arriver à ce que les deux images de l’objet soient superposées. L’autofocus découle de se principe.

6. Quelques programmes sur ordinateur

6.1 Adobe Photoshop (WindowsOs et MacOs)

Intéressons-nous à un programme : Photoshop d’Adobe ©. C’est l’un de ces nombreux programmes qui permettent de faire de la retouche d’image, c’est le plus répandu car c’est l’un des plus complet, mais il est aussi l’un des plus compliqué à utiliser, et au contraire de Gimp, il est payant, et même assez cher pour un programme, mais ça en vaut vraiment la peine si on a les moyens. Il est non seulement téléchargeable sur le net, sur le site d’Adobe, mais il se trouve aussi sur CD-ROM, que l’on retrouve dans les magasins. Il permet de travailler à partir d’une photo, d’une image existante ou bien à partir d’une feuille blanche. Grâce à ses divers outils de travail, l’on peut faire des photomontages, l’on peut créer des effets sur des photos, comme l’effet "vitrail" qui crée l’illusion que la photo est un vrai vitrail qu’on pourrait voir dans une église, ou l’effet "texture" qui donne l’impression que la photo a été imprimée sur un bout de tissu. Il y a bien sûr d’autres effets disponibles et sur chacun d’entre eux, l’on peut modifier les paramètres et on peut même créer les nôtres. Tous ces effets peuvent être appliqués en même temps sur une zone définie, par exemple on peut avoir un bout de la photo où on aura l’effet « ombre », un autre endroit avec l’effet « vitrail », un autre avec l’effet « négatif », etc.

6.2 Gimp (LinuxOs, WindowsOs et MacOs)

Gimp est un programme qui permet, comme Photoshop, de créer et modifier des images numériques. Le gros atout de ce logiciel, c’est qu’il est totalement gratuit ; on peut le télécharger sur le site de Gimp ou bien le trouver en kiosque dans des magazines informatiques ; il ne vous coûtera que le prix de la revue. En fait, des bénévoles font le développement pendant leurs temps libre, tous avec des bonnes connaissances en informatique, surtout en programmation, peut faire avancer le « schmilblick ». Il peut fonctionner sur tout les programmes d’exploitation, Linux (programme sur lequel Gimp a commencé à être développé), Windows de Microsoft © et aussi sur Mac, ce qui fait que vraiment tout le monde peut en bénéficier, bien sûr à condition de posséder internet ou d’acheter une revue. Le seul défaut face à Photoshop est le manque de stabilité sous les OS de Microsoft.

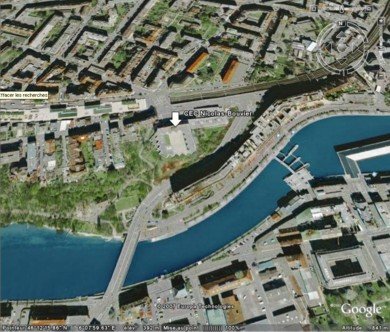

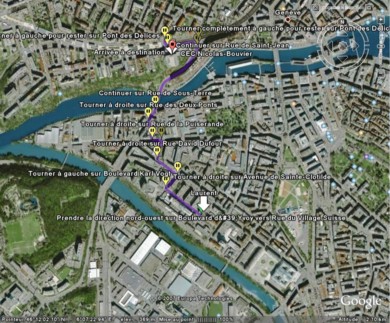

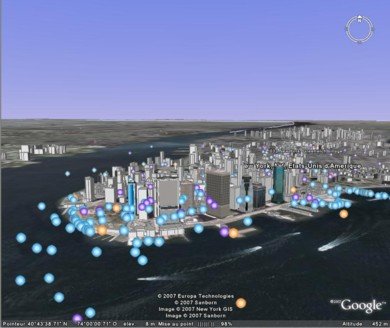

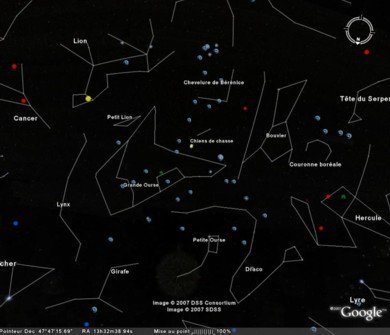

Le plus célèbre des moteurs de recherche sur internet, Google, a créé un programme après avoir collecté des photos satellite de la terre et les avoir modélisées sur ordinateur : Google Earth. Mais quel est le lien avec la photographie ? Les satellites "voient" toutes les longueurs d’ondes, UV, IR, Radio etc... et ils sont aussi des appareils numériques géants. Ils possèdent des zooms allant jusqu’à une précision de quelques centimètres alors qu’ils sont à plus de 700 kilomètres du sol ! Il existe différentes versions, professionnelle, entreprises, une version qui prend en compte les systèmes GPS et surtout une version grand public et totalement gratuite que l’on peut télécharger sur le site de Google. Alors ce programme à quoi peut-il bien servir ? Et bien l’on peut faire des tas de choses avec, par exemple chercher un itinéraire, comme avec Via Michelin, faire le tour du monde en restant devant son ordinateur ; il remplace le bon vieil Atlas. Il y a des petites options qui sont fort utiles, comme Google Maps qui permet de mettre en évidence des commerces ou des services à l’endroit voulu ou encore un éventail d’informations pratiques comme les routes, les hôtels, les restaurants, les transports, les parcs, etc. il y a la possibilité de mettre un repère n’importe où, sur terre ou dans l’espace, comme celui ci-dessous. Il est régulièrement mis à jour, et propose de plus en plus de fonctions. Une des grosses mise à jour fut la toute nouvelle information pratique : la fantastique possibilité de voir des bâtiments et monuments connus en 3D, comme la Tour Eiffel ou encore presque Manhattan en entier. Depuis la dernière mise à jour, on dispose d’une carte des étoiles où les constellations sont mises en évidence ; on a la chance de pouvoir voyager dans l’espace comme on le veut et aller voir ce qu’on veut. Google Earth est non seulement un programme utile, pour faire des itinéraires, mais aussi éducatif car l’on peut apprendre le nom des capitales en s’amusant. Il y a de plus en plus d’informations déposées par des agences comme le WWF, la NASA, la ESA (l’Agence Spatiale Européenne), l’UNEP (United Nations Environment Programme) ou encore la chaîne de télévision Discovery Channel et bien d’autres. Le gros point fort c’est la grande qualité des données (photos satellites, nombreuses options) et surtout la gratuité d’une version complète et non pas d’une simple version de démonstration.

Panoramio est un programme intégré à Google Earth. Il fonctionne aussi exclusivement par internet. Son intérêt réside dans le fait que tout le monde peut mettre des photos en rapport avec un lieu, un monument d’une ville, et ainsi alimenter une bibliothèque mondiale de photos. Il est très facile à utiliser, il suffit de s’inscrire gratuitement et de choisir les photos qu’on veut mettre en ligne à la disposition de tout le monde et d’attendre trois à quatre semaines, le temps de les traiter, elles seront disponibles.

7. Conclusion - ce qui a changé

Le numérique a redonné envie aux gens de faire de la photo. On n’hésite plus à sortir notre appareil par peur de gâcher une pellicule. Que se soit les appareils ultra plat et compact qui sont proposés dès 200 francs ou bien des réflex qui eux dépasse la barre des 1000 francs et bien souvent des 2000, chacun a la possibilité d’acheter l’appareil qui lui convient. Par exemple un adolescent débutant prendra un appareil avec beaucoup de pixels en croyant que ses photos seront plus belles (ce qui n’est pas faux mais si on compte faire des posters car sinon 3.2 millions de pixels suffisent pour des photos standard 10 X 13) et avec pleins de gadgets intégrés comme des mini softwares qui permettent des modifier les photos directement sur l’appareil, ou encore la possibilité de faire des films. A côté de lui, une personne plus éclairée, disons un amateur ou un professionnel, prendra un réflex qui sert juste à faire des photos, il est en effet dépourvu des tous les gadgets superficiels mentionnés plus haut. Le développement du numérique a mis en avant un autre marché, celui des logiciels de retouches, par exemple Photoshop d’Adobe, qui permettent de modifier une photo sur ordinateur. Même Microsoft en a intégré un dans son célèbre programme d’exploitation Windows XP et maintenant Windows Vista.

Avec les progrès dans le monde de l’informatique, le numérique a été intégré dans d’autres appareils, je pense notamment aux téléphones portables et autres lecteurs MP3 et agendas électroniques. Tous ces changements sont positifs ; on va vers un monde où tout sera centralisé, regroupé sur un seul appareil.

Ce travail m’a permis d’apporter des réponses à mes interrogations. Je suis moi-même dans la peau de monsieur tout le monde, c’est-à-dire très loin d’égaler le niveau de connaissance de certains amateurs en matière de photographie. J’ai essayé de me consacrer à un seul domaine, le numérique, pour plusieurs raison : d’abord on baigne dedans, c’est la mode, tout le monde possède un appareil numérique, on a oublié l’argentique, le pauvre reste au fond du placard et il ne sait pas s’il va remettre l’objectif dehors, en tout cas ça va pas se faire tout de suite. Les recherches n’ont pas été faciles pour trouver un livre expliquant autre chose que comment utiliser son appareil numérique pour faire une belle photo. Bien évidement j’ai eu recourt à internet (qu’est-ce qu’on ferait sans lui maintenant ?) pour trouver mes informations, mais j’ai eu aussi l’aide de Monsieur David Houdebert qui m’a conseillé quelques site intéressants et m’a expliqué le fonctionnement général d’un numérique. Pour finir, j’ai beaucoup apprécié ma rencontre avec Monsieur Grob, pour la petite interview somme toute très générale sur le domaine traité ci-dessus. On pourrait passer des années à faire un travail approfondi, tant le flot d’informations est considérable et constamment remis à jour, notamment grâce à internet.

Je voudrais tout d’abord remercier Monsieur Richard Forster qui m’a mis en contact avec Monsieur Patrick Grob photographe professionnel et a eu la gentillesse de répondre à quelques questions ; finalement je voudrais remercier Monsieur David Houdebert qui m’a fait don de ses précieux conseils et connaissances de le photographie.

Ouvrages :

Adair King, J. (2003). Photo numérique pour les nuls. Paris : Éditions First Interactive.

Ang, T. (2002). Le guide de la photographie numérique. Vevey : Editions Mondo

Bajac, Q. (2001). L’image révélée. L’invention de la photographie. Paris : Gallimard.

Bouillot, R. (1991). Cours de photographie. Paris : Dunod.

Charpié, J. (1989). Traité de photographie. Paris :Editions VM

Internet :

– http://www710.univ-lyon1.fr/~fdenis...

– http://blog.ifrance.com/laulau2802/...

– http://fr.wikipedia.org/wiki/Appare...

– http://fr.wikipedia.org/wiki/Charge...

– http://fr.wikipedia.org/wiki/Codage...

– http://fr.wikipedia.org/wiki/Compre...

– http://fr.wikipedia.org/wiki/Distor...

– http://fr.wikipedia.org/wiki/Graphi...

– http://fr.wikipedia.org/wiki/Mise_a...

– http://fr.wikipedia.org/wiki/Norme_JPEG

– http://fr.wikipedia.org/wiki/Object...

– http://fr.wikipedia.org/wiki/Pellic...

– http://fr.wikipedia.org/wiki/Photog...

– http://fr.wikipedia.org/wiki/Run-le...

– http://fr.wikipedia.org/wiki/Window...

– http://fr.wikipedia.org/wiki/Joseph...

– http://ressources2.techno.free.fr/i...

– http://sechtl-vosecek.ucw.cz/en/exp...

– http://zipi.unblog.fr/equipement/

– http://www.ac-nice.fr/philo/textes/...

– http://www.adobe.com/fr/products/ph...

– http://www.astrosurf.com/luxorion/p...

– http://www.astrosurf.com/luxorion/p...

– http://www.blogg.org/blog-13541-dat...

– http://www.butkus.org/chinon/ebay/c...

– http://www.canon.fr/for_home/produc...

– http://www.canon.fr/For_Home/Produc...

– http://www.chez.com/photoimage/hist...

– http://www.clubic.com/article-14325...

– http://www.collection-appareils.com...

– http://www.commentcamarche.net/vide...

– http://www.commentcamarche.net/vide...

– http://www.crdp.ac-grenoble.fr/imag...

– http://www.digicamhistory.com/1940s.html

– http://www.echoshop.be/catalog/obje...

– http://www.electronique.biz/article...

– http://www.gimp.org/

– http://www.lac.u-psud.fr/experience...

– http://www.memo.fr/article.asp?ID=T...

– http://www.museecinemaphoto.com/pho...

– http://www.nidinfo.com/html/mavica.html

– http://www.niepce.com/pages/hist1.html

– http://www.nikon.ch/product/fr_CH/p...

– http://www.nikon.ch/product/fr_CH/p...

– http://www.nikon.ch/product/fr_CH/p...

– http://www.nikon.ch/product/fr_CH/p...

– http://www.nndb.com/people/212/0001...

– http://www.oplusplus.com/francais/r...

– http://www.photographiz.com/mise_au...

– http://www.pictchallenge-archives.n...

– http://www.toenisheide-live.de/Equi...

Interview de Patrick Grob photographe professionnel « freelance » le mercredi 19 septembre 2007 à 19h00 :

Qu’est-ce qui vous a donné envie de devenir photographe ?

« Je n’ai pas toujours été photographe mais j’ai toujours fait de la photo, depuis l’âge de douze-treize ans. J’ai été commercial pendant dix ans puis un jour j’ai pété les plombs et j’ai tout quitté. Je me suis consacré à la photo et ça a marché. »

Quel était votre premier appareil photo ?

« Alors… (pensif) c’était un Chinon CM-5 que j’ai eu à treize ans. C’était un boîtier 24X36 en 50 mm, tout manuel. »

Et maintenant quel matériel possédez-vous et pourquoi celui-là ?

« Cela dépend. J’ai mon matériel, à savoir un Canon EOS-1D Mark II et un Canon EOS-30D, et j’emprunte celui des différentes agences pour lesquelles je travaille. Je bosse exclusivement avec Canon par habitude et non par choix, c’est comme les natels, quand on est habitué à un Nokia ©, c’est difficile de passer à un Motorola ©. »

Pourquoi être passé au numérique ?

« Pratique et nécessaire. Aujourd’hui on doit rendre les images quasiment à la minute aux agences. Par exemple hier j’étais à Lausanne pour couvrir la manifestation qui à commencé à 17h30 et à 18h30 les photos étaient déjà en ligne. A l’époque de l’argentique cela mettait deux, trois jours avant de paraître, donc bosser en argentique est devenu beaucoup trop lent. »

Que pensez-vous des progrès techniques effectués dans l’univers de la photographie ?

« Il y a du positif et du négatif. Le positif c’est qu’on a un contrôle direct de ce qu’on fait, si on se plante on le sait tout de suite et on peut le corriger. Ensuite, cela a instauré de la concurrence. Avant un photographe prenait une photo qu’on retrouvait aux quatre coins du monde, maintenant les agences reçoivent des centaines de photos d’un même évènement, on les retrouve disséminées un peu partout, c’est plus varié.

Le négatif c’est que les photos sont trop vite envoyées et si on a eu des mauvaises informations sur l’évènement qu’on a photographié, bah c’est trop tard car la photo est déjà en ligne et dans les journaux. Je prend un exemple, un photographe français, Patrick Chauvel, en 1980 au Liban lors du conflit entre les différentes religions, a pris une photo d’un prêtre de la communauté chrétienne, qui elle n’était pas en conflit, en train de tirer sur les arbres d’une forêt avec une mitrailleuse lourde. Ce photographe avait déjà envoyé par avion ses photos, parmi lesquelles se trouvait celle-ci, à son agence. Le lendemain le prêtre lui a demandé de ne pas faire paraître cette photo car cela pourrait prêter à confusion et influencer le sort du conflit. Le prêtre a expliqué au photographe qu’il avait pété les plombs à cause de toute cette pression, que le diable l’avait possédé et qu’il n’aurait jamais dû faire ça. Le photographe a tout de suite téléphoné à son agence pour la prévenir de ne pas publier cette photo. Il a ainsi peut être évité que le village du prêtre ne soit rasé le lendemain par les musulmans.

Le photographe n’a pas le droit d’influencer l’opinion, on n’a pas le droit à l’erreur. »

Pour vous quel est l’avantage principal des appareils numérique par rapport aux argentique ?

« La rapidité, la possibilité de corriger les erreurs, de savoir où on en est. Mais il y a tout de même un désavantage, on prend quatre fois plus de photos qu’avant, aujourd’hui on tourne autour des huit cent photos alors qu’avant on était plus autour des cent à cent cinquante. Et le truc c’est que quand on a huit cent photos à classer sur l’ordinateur on perd beaucoup de temps. »

Est-ce plus agréable de travailler avec un numérique qu’avec un argentique ?

« Alors pour le boulot c’est le numérique, c’est le plus facile après pour certains travaux de commande où il faut de la qualité, j’utilise l’argentique, mais bon il faut avoir du temps. Je l’utilise aussi dans des situations difficiles, par exemple en Amazonie, où un numérique dure deux heures et après il est mort à cause de l’humidité. »

Vos méthodes de travail ont-elles été modifiées ?

« Radicalement, on prenait une photo, ensuite il fallait aller la faire développer au labo de l’agence, puis scanner les négatifs, tout cela prenait énormément de temps. Bon quand on est à la plaine de Plainpalais et qu’on travaille pour la Tribune de Genève, ça va mais quand on est au Liban ce n’est pas la même chose, il faut porter les photos à l’aéroport, le temps qu’elles arrivent, etc. Un exemple : tu as déjà vu des photographes lors d’un match de foot ? Ils ont souvent un ordinateur portable à côté d’eux, ils ont enfaîte une petite antenne sur leur boîtier et une sur le portable et lorsque le photographe prend une photo, elle est instantanément envoyée du boîtier sur l’ordinateur puis de l’ordinateur à l’agence pour laquelle ou lesquelles il bosse. Tu vois le temps que ça prend, en moins d’une minute la photo est prête à être publiée. »

On entend souvent dire que les photos de certains magazines à scandale sont retouchées, je voulais savoir si vous vous utilisiez des programmes, comme Photoshop, pour retoucher vos photos avant qu’elles ne paraissent ?

« Il existe une ligne éditoriale propre à chaque agence, qui fixe le niveau de retouche que l’on peut apporter aux photos, par exemple l’agence Keystone veut très très peu de retouche, voir pas du tout, tout juste pour améliorer le contraste mais en aucun cas fausser l’image. Après il y en a d’autres….. Il y a aussi l’étique du photographe. Par exemple en 2004 – 2005 il y a eu une photo où l’on voyait un soldat américain menacer une petite irakienne de huit, dix ans avec son arme. En fait on s’est rendu compte que sur une photo du même photographe mais prise trente secondes avant il n’y avait pas la petite irakienne, il a donc fait un photomontage. Je sais que moi j’étais en Irak en 2003 lors de l’invasion et j’étais vers un immeuble qui avait reçu deux bombes, en bas il y avait une chaussure, qui avait dû être projetée lors de l’explosion, mais elle était vers des buissons touffus et je ne pouvais pas me glisser dedans pour prendre la chaussure avec l’immeuble en fond. J’ai passé un quart d’heure à réfléchir à si je devais la déplacer d’un mètre pour faire une belle photo. Finalement je ne l’ai pas fait et j’ai fait une mauvaise photo (rire). »

Quel matériel conseilleriez-vous à une personne débutant dans la photographie ? Apprendre avec un argentique ou tout de suite avec un numérique ?

« Tout de suite avec un numérique car ça va plus vite pour apprendre, on voit le résultat, par exemple si l’on change un réglage on voit immédiatement l’effet et non dans trois jours quand on aura oublié le réglage qu’on avait fait. Je conseillerais un réflexe et non un compact, pas besoin de prendre un boîtier à cinq mille francs mais déjà un entre huit et neuf cent francs suffit. »